「画像認識の現状認識:ディープラーニングの成功と限界?」岡谷 貴之 (東北大学)「日本人のための音声対話による英会話学習システム」伊藤 彰則 (東北大学)

画像認識の現状認識:ディープラーニングの成功と限界?

Mamoru Komachi

@mamoruk

Mamoru Komachi

@mamoruk

本日は10:30から NL研・SLP共催研究会の招待講演で、東北大学の岡谷先生による「画像認識の現状認識:ディープラーニングの成功と限界?」を配信します!ustream.tv/channel/ipsj-s… #signl #sigslp nl-ipsj.or.jp/NL221program.h…

2015-05-26 09:59:49 Mamoru Komachi

@mamoruk

Mamoru Komachi

@mamoruk

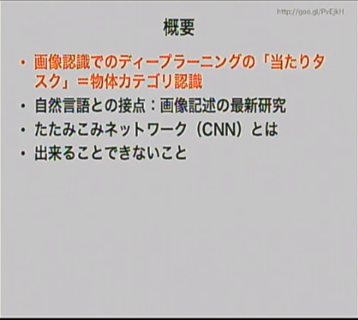

早くから deep learning に取り組んでいた。なぜ deep learning が画像認識で有効か? ということを考えている。画像認識での「当たりタスク」は物体カテゴリ認識だった。自然言語処理でもそのような「当たりタスク」があると思う。#signl #sigslp

2015-05-26 10:33:53 Aki Ariga

@chezou

Aki Ariga

@chezou

物体カテゴリ認識がディープラーニングの「当たりタスク」とは端的だ #signl #sigslp pic.twitter.com/8x2PfTGUzK

2015-05-26 10:34:16 拡大

拡大

Mamoru Komachi

@mamoruk

Mamoru Komachi

@mamoruk

物体カテゴリ認識タスクについて。様々な課題があり、伝統的には人間には簡単だが機械には難しい問題とされていた。ここに深層学習は効果があった。アーキテクチャはたたみこみニューラルネット。たたみこみ層とプーリング層の繰り返し構造を持ち、教師あり学習可能。#signl #sigslp

2015-05-26 10:36:09 Mamoru Komachi

@mamoruk

Mamoru Komachi

@mamoruk

物体カテゴリ認識の教師あり学習。入力は写真そのもの。誤差逆伝搬と勾配効果法で教師あり学習できる。これが可能になったのは学習データが貢献大。WordNetに紐付いた1,400万枚の画像が含まれたImageNetが強力。1,000枚/カテゴリある。#signl #sigslp

2015-05-26 10:39:42 Mamoru Komachi

@mamoruk

Mamoru Komachi

@mamoruk

誤差逆伝搬と勾配降下法にミニバッチ(100個くらいのサンプルで重み更新)を組み合わせると、いまどきの GPU で2-3日くらいで学習できる。最後の出力層に softmax をかけると、不思議と所望のカテゴリだけ高い確率が出力できるようになる。#signl #sigslp

2015-05-26 10:42:29 Mamoru Komachi

@mamoruk

Mamoru Komachi

@mamoruk

物体カテゴリ認識は AlexNet から GoogLeNet へ。基本的に層の数を増やして発展。人間に同じタスクをさせて比較すると、ほぼ人間(専門家)の領域に達している。人間も予習しないと分からない。素人では深層学習に勝つのは厳しくなっている。#signl #sigslp

2015-05-26 10:44:37 Mamoru Komachi

@mamoruk

Mamoru Komachi

@mamoruk

顔画像認識は深層学習登場以前から機械でもそこそこできたが、深層学習の登場によりさらに深化した。#signl #sigslp

2015-05-26 10:45:42 Mamoru Komachi

@mamoruk

Mamoru Komachi

@mamoruk

特徴・表現の学習。これまで素性を手で設計・データから重みを学習していたが、深層学習(CNN)は素性の設計から機械学習をするところが新しいパラダイム。特徴自体を学習するので、最後の分類自体は線形分類器でもよい。#signl #sigslp

2015-05-26 10:48:14 Mamoru Komachi

@mamoruk

Mamoru Komachi

@mamoruk

深層学習の長所。特徴(素性)を学習するので、あるタスクのために学習したモデルをそのまま別のタスクに使うことができる。分野適応と考えることもできる。新しいタスクが登場しても、既存のタスクで訓練したものをとりあえず持ってくればそこそこの精度のものができる。#signl #sigslp

2015-05-26 10:50:12 Aki Ariga

@chezou

Aki Ariga

@chezou

@unnonouno なるほどー。画像じゃないと音声系とかですかねー。画像+LSTMとのマルチモーダル系はNLPの人にも面白そうなんですけどね

2015-05-26 10:51:16 Mamoru Komachi

@mamoruk

Mamoru Komachi

@mamoruk

自然言語との接点ということで、CVPR 2015 の紹介。画像記述の研究がたくさん。全部たたみこみニューラルネット。Vinyal ら(Google)は CNN+LSTM。CNN は物体認識を訓練した GoogLeNet、LSTMは翻訳用の流用。#signl #sigslp

2015-05-26 10:52:24 Yuya Unno

@unnonouno

Yuya Unno

@unnonouno

@chezou 音声もありですけど、SLPと一緒にやるくらいですからもともと近いといえば近い。もう少し軸を変えて、実装屋とか計算機屋とかのほうがいいかも

2015-05-26 10:54:17 Aki Ariga

@chezou

Aki Ariga

@chezou

KL reguralizationなんてあるのか / “音声認識分野における深層学習技術の研究動向” htn.to/ci2RhGs

2015-05-26 10:54:41 Mamoru Komachi

@mamoruk

Mamoru Komachi

@mamoruk

画像を1回だけ CNN に食わせてあとは LSTM (RNN) で文を生成する流儀と、毎回 CNN に食わせる流儀とある。画像も全体を使ったり、一部だけ切り出したり、LSTM も2層にしたり、双方向にしたり、いろいろある。#signl #sigslp

2015-05-26 11:00:00 Mamoru Komachi

@mamoruk

Mamoru Komachi

@mamoruk

MSR の Fang らの CVPR 2015 の研究。他の研究は LSTM で文生成するが、この研究の違うのは、画像から word detector というので単語を切り出し、そこから文を生成し、リランキングする、という3ステップで画像記述をする点。#signl #sigslp

2015-05-26 11:01:43